ABB

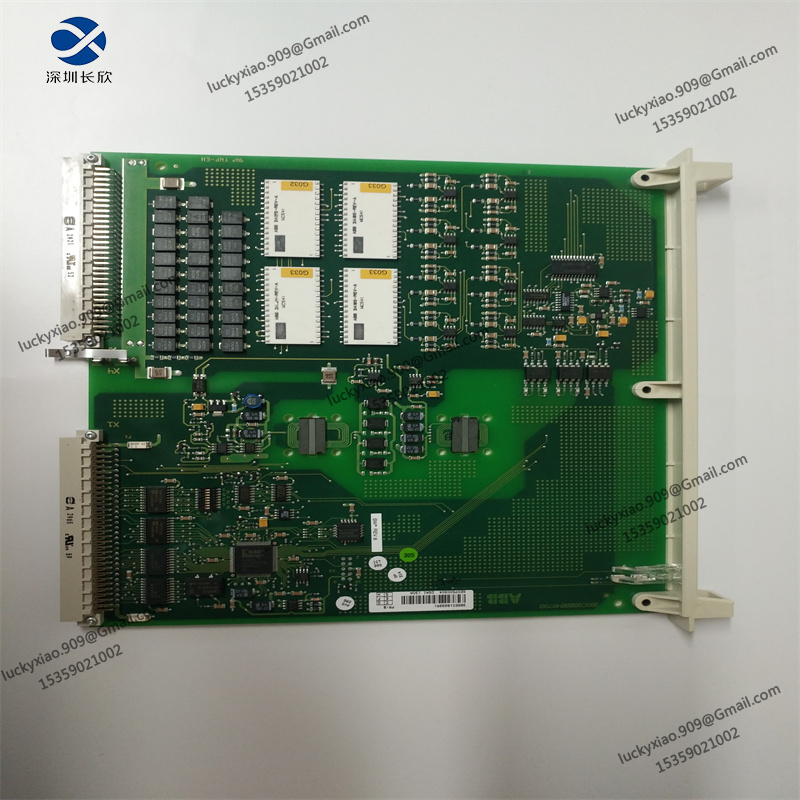

ABB DSAI130A 3BSE018292R1机器人备件

- 品牌:ABB

- 型号:DSAI130A

- 发货时间:3-5天

- 质保:365天

- 联系人:肖小姐

- 电话:15359021002(VX同号)

- WhatsApp:+86 15359021002

- Skype:+86 15359021002

- 邮箱:luckyxiao.909@gmail.com

- 外贸官网:www.shenzhencx.com

-

产品详情

1. 机器学习就绪数据的可用性

虽然这听起来是一个简单的问题,但为机器学习模型准备数据是一个巨大的挑战。数据科学家和数据工程师通常将80% 的精力花在数据准备上。如果没有专为人工智能设计的干净数据,就不可能训练人工智能模型以使其做好生产准备。不幸的是,失败经常发生。Gartner 发现85% 的人工智能项目未能交付,只有 53% 的项目从原型转向生产。

许多组织提供用于自动化目的的机器学习就绪数据集,例如用于持续改进流程模型的流程执行数据,这可以加快培训时间并显着减少数据科学家和数据工程师所需的工作量。任何时候这些高价值员工能够将时间分配到其他地方都是关键——他们往往供不应求,但需求量很大。

2. 模型的准确性问题和偏差

准确性和偏差是人工智能中两个关键但反复出现的问题,需要人工监督。例如,生成式人工智能应用程序很容易产生幻觉,或者根据训练数据集编造事实。同样,输入机器学习模型的有偏差的数据集可能会产生有偏差的结果。例如,如果一家金融服务公司使用人工智能驱动的自动化系统来接受或拒绝信贷申请,则必须避免训练数据集中可能包含的针对女性或有色人种的有据可查的系统性偏见。

随着我们向人工智能驱动的决策迈进,人类保持在循环中至关重要,验证机器学习算法生成的结果以检查偏差和其他形式的不准确性。让人类参与其中是重新训练算法以在生产环境中更有效地执行的关键一步。

3. 安全性

许多大型语言模型和其他机器学习模型已经使用互联网用户生成的大量在线数据进行了训练。例如,公开的 Amazon 和 Yelp 评论用于训练情感分析算法。

在企业环境中,使用 ChatGPT 等公开可用的模型可能会对个人身份信息 (PII) 或知识产权等敏感数据造成风险。使用这些工具时,遵守公司的数据安全政策非常重要。为了避免此类问题,许多组织基于内部数据集开发了自己专有的机器学习模型,从而降低了企业数据落入坏人之手的风险。

4、法律风险

监管人工智能是全球范围内持续存在的问题,法律领域继续受到包括生成人工智能在内的新兴技术的影响。例如,许多人对人工智能生成的文本和图像的使用提出了版权担忧。在开源世界中,自动代码生成器引起了人们对许可的担忧。一些关键问题在于生成式人工智能系统缺乏可追溯性,换句话说,很难知道代码来自哪里以及如何将其归因于其原始创建者。

例如,如果组织使用自动代码生成器来开发流程模型的代码,那么在输入专有代码或利用开源软件时最好谨慎行事。

5. 成熟度

某些技术,例如自动决策的增强智能系统,可能尚未完全准备好迎接黄金时期。这些技术通常需要来自多个来源的混合数据集才能做出有效的决策。许多团队没有能力在生产中使用这些系统,无论是由于资源限制还是缺乏适用的培训数据。

然而,随着组织的成熟并可以在人类监督的环境中使用增强智能,这些系统将在自动化某些决策方面变得更加有效。此类系统可以帮助改善人类工作流程,使员工能够更有效地分配时间。

虽然这些挑战肯定会影响任何实施人工智能的决策,但它不应该抑制组织进行实验的意愿。人工智能与流程编排一起使用时,有可能提高自动化程度,从而改善业务运营和客户体验。从持续的流程改进,到自动化决策,再到增强或加速人类工作流程——人工智能在这个领域的可能性是令人兴奋和无限的。

栏目导航

新闻资讯

联系我们

电 话:15359021002

联系人:肖小姐

手 机:15359021002

邮 箱:luckyxiao.909@gmail.com

地 址:深圳市宝安区西乡街道臣田社区宝民二路东方雅苑2层B39